MapReduce 兩次統計樣例程序:解析大數據處理的關鍵步驟

一、MapReduce的魅力開場

MapReduce,這名字多霸氣,像不像超級英雄?在大數據的領域里,它就像是個無敵英雄,專門處理那些巨量又雜亂的數據集。比如,你有座巨型數據倉庫,擺滿各種類型的數據,MapReduce就能化腐朽為神奇,把它們變成真金白銀。今天咱們就來看看,MapReduce是怎么用兩個簡單的統計樣例程序展示它的超能力的。

首先得知道,MapReduce不只是個工具,它是解決難題的一種方法,把大問題拆分成小塊,一個個搞定。這樣一來,處理大數據就沒那么嚇人了,反倒挺有意思的。

二、Map階段:數據的初步探索

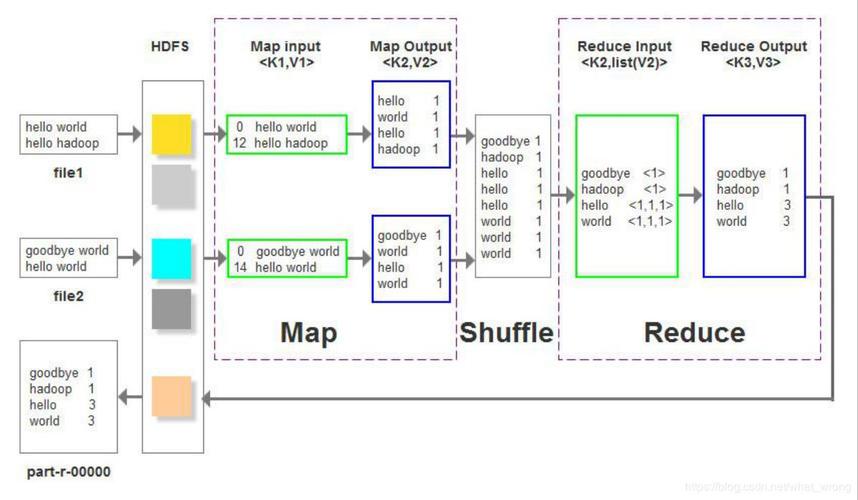

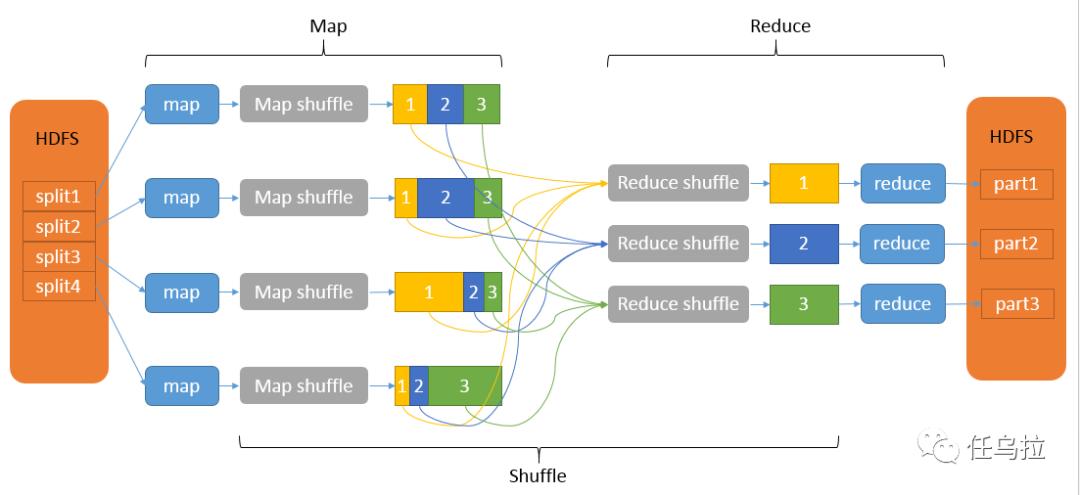

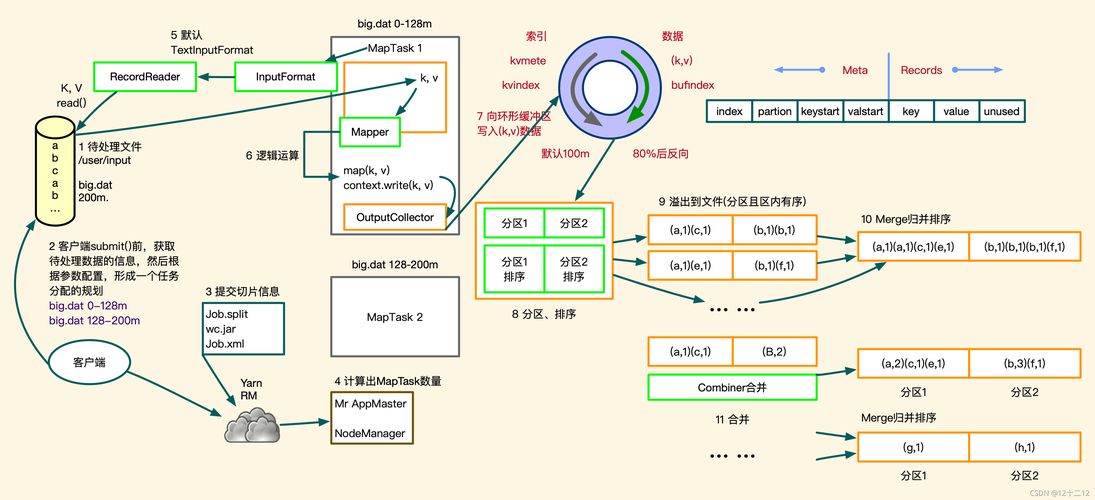

說到MapReduce,你得知道Map環節就是偵探的“開局”動作!它接過大量的輸入數據,逐個搞掂它們,制造出一堆看似普通卻很關鍵的中間結果。這些中間結果,就像用小本子記錄的現場證據,雖然還不咋能看清楚真相,但對后面的破案可是大有幫助!

舉個例子假設要咱們統計社交網絡里的好友數量。在"映射"這個步驟中,咱們會逐行讀取數據,每行都是倆好友的名字,比如"華仔,郭靖".然后,我們給每個好友組合起個名字,就是他們名字的順序(為了確保每組好友都獨一無二~),再給它配上一個數字1。這樣,原來那些亂糟糟的數據就變成了更容易理解和使用的中間結果!

三、Shuffle和Sort階段:線索的整理

map環節后,結果亂七八糟的,就像一地的線頭一樣煩人。然后shuffle+sort這倆大兄弟就幫咱們把相同鍵的結果擺放整齊,最后好讓reduce來清一清。

咱接著上回的例子,在shuffle和sort環節過后,所有叫"華仔,郭靖"的數據都聚堆兒。這時候咱們就可以進行最后的大匯總!

四、Reduce階段:真相大白

Reducer階段,就是MapReduce流程通關的最后一個步驟,也是最關鍵的那一下子。這時候,Reduce函數把所有數據集中起來,把每個鍵對應的數值搞清楚,然后咱們想要的結果就出來了。整個過程,就像大偵探破案,拿著那些線索,一點點推理出事實的真相。

咱們做好友對數統計時,Reduce階段就是把每個鍵的數值加起來,最后算出總共的好友對數。這樣,任務就搞定!

五、另一個案例:單詞頻率統計

比起好友對數統計,你可能更想知道如何通過MapReduce來完成其他任務,比如單詞頻率統計!它可是能幫我們計算出一段文本哪個詞兒最多,聽上去挺有意思~

在Map階段,就是把長長的文章切成一個個小詞,然后給每個小詞配上一個鍵值對。這個鍵很簡單,就是小詞本身;至于值,就是數字“1”!這樣,原本的文本數據就變得像個半成品一樣~

shuffle跟sort這兩步,其實就是把所有相同的鍵值(也就是同一個單詞)給弄到一起去。然后,就可以準備好開始reduce階段。

在Reduce階段,那個叫Reduce的函數就會給每個鍵算一下它對應的值總共是多少次,最后就能得出所有單詞出現的總數!這樣子,咱們就把單詞出現頻數的活兒搞定了。

六、MapReduce的容錯機制

MapReduce不只是個運算神器還有超強的防出錯功能!在Map環節里,大數據被切成小塊兒,每塊交給一個Map任務搞定。要是哪個任務掛了的話,對別的事情也沒影響!而且,MapReduce在傳數據的時候還會用上備份手法定時備份,保證數據安全無虞!

就算Reduction環節里有個工作失敗,我們依然可以重啟它,不影響最終效果!這個強大的防錯功能保證了MapReduce處理大容量數據的穩定性和可靠性。

七、MapReduce的適用場景

MapReduce很牛,但是有些時候用起來就不太劃算了。像要快速反饋或數據不多的情況下,可能用MapReduce就有點浪費資源。還有那種經常讀取寫入的任務,試試別的模型,比如ApacheSpark,這個效率更高!

但如果你要處理大批量數據?那MapReduce絕對是最好的選擇!它通過分布式運算,讓處理大數據就像切菜一樣輕松。

八、總結與展望

MapReduce是個牛逼的大數據處理工具,它讓大規模數據處理變得超快,特適合批處理那種大批量的數據。搞過兩次實驗后,咱們才真正明白MapReduce怎么運作而且在實際情況下能有多厲害。

以后,咱們的數據會越來越多,那時候,學點MapReduce和其他大數據處理工具就顯得尤為關鍵了。如果你是搞這行的,要好好理解并熟練運用這些工具,這可是必不可少的技能!

關于這個話題,你們會不會經常碰到需要整理很多數據的情況?那么你們都是怎么應對這類麻煩事的?膜拜大神們分享你們的想法,讓我們互相理解,共同提高。

點贊轉發讓更多人領略MapReduce的魔力!

作者:小藍

鏈接:http://www.yunyix1.cn/content/715.html

本站部分內容和圖片來源網絡,不代表本站觀點,如有侵權,可聯系我方刪除。